Meta เปิดตัว Llama 4 Herd รุ่นใหม่ เสริมแกร่งด้วยเทคโนโลยี AI แบบผสมผสาน

Meta ได้เปิดตัวโมเดล AI รุ่นล่าสุดในซีรีส์ Llama 4 ซึ่งถือเป็นก้าวสำคัญในวงการปัญญาประดิษฐ์ โมเดลเหล่านี้ถูกออกแบบให้รองรับหลายรูปแบบข้อมูล (multimodal) โดยสามารถผสมผสานข้อความ ภาพ และวิดีโอเข้าด้วยกันในโมเดลหลักเดียว นวัตกรรมนี้ใช้วิธีการผสานข้อมูลแบบ early fusion และสถาปัตยกรรม Mixture-of-Experts (MoE) ซึ่งช่วยเพิ่มประสิทธิภาพในการประมวลผลโดยเลือกใช้เฉพาะบางส่วนของพารามิเตอร์ทั้งหมดสำหรับแต่ละข้อมูลที่ป้อนเข้าไป การออกแบบนี้ช่วยปรับปรุงทั้งกระบวนการฝึกฝนและการอนุมานอย่างมีนัยสำคัญ

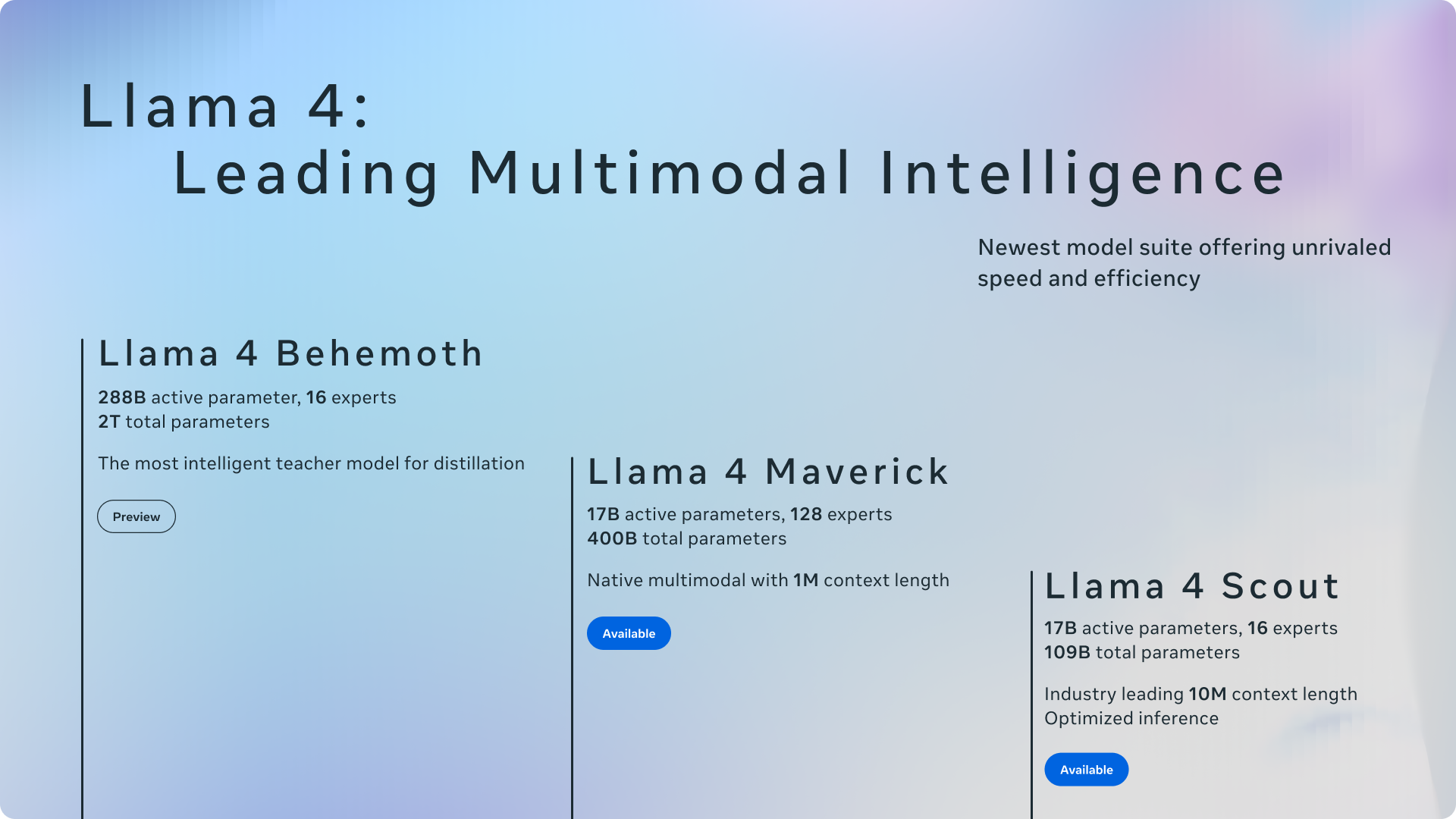

ซีรีส์ Llama 4 ประกอบด้วยโมเดลหลักสามรุ่น ได้แก่ Llama 4 Scout, Llama 4 Maverick และรุ่นพรีวิวที่เรียกว่า Llama 4 Behemoth โดย Llama 4 Scout โดดเด่นด้วยหน้าต่างบริบทที่กว้างขวาง ทำให้เหมาะสำหรับงานที่ต้องการการวิเคราะห์แบบครอบคลุม ส่วน Llama 4 Maverick มีความเชี่ยวชาญในงานผู้ช่วยทั่วไปและการทำความเข้าใจภาพอย่างแม่นยำ รองรับ 12 ภาษา ขณะที่ Llama 4 Behemoth เป็นโมเดลขนาดใหญ่ที่มีความสามารถน่าประทับใจ เหนือกว่าคู่แข่งในการวัดผลด้าน STEM โมเดลเหล่านี้เป็นแบบโอเพนซอร์สและสามารถเข้าถึงได้บนแพลตฟอร์มต่างๆ เช่น Hugging Face และ GroqCloud ทำให้นักพัฒนาสามารถนำไปใช้ในแอปพลิเคชันที่หลากหลาย

การเปิดตัวโมเดล Llama 4 มีเป้าหมายเพื่อเสริมพลังให้นักพัฒนาสามารถสร้างประสบการณ์ AI ที่เป็นส่วนตัวและซับซ้อนมากขึ้นในหลากหลายด้าน ด้วยการมีให้บริการบนแพลตฟอร์มอย่าง GroqCloud นักพัฒนาสามารถใช้ประโยชน์จากโมเดลเหล่านี้ในราคาที่แข่งขันได้ พร้อมรับรองประสิทธิภาพสูงและความหน่วงเวลาที่คาดการณ์ได้ ลักษณะโอเพนซอร์สของ Llama 4 ส่งเสริมนวัตกรรมและการปรับตัว ช่วยให้สามารถสร้างแอปพลิเคชัน AI ที่ปรับแต่งได้ซึ่งลดอุปสรรคด้านภาษาและรองรับการใช้งานที่หลากหลาย

ที่มา: GroqCloud